Ranking najszybszych kierowców F1 w historii, czyli dlaczego nie wolno bawić się liczbami

Ostatnio modyfikowany 4 lata temu przez Marcin Błażejowski.

18 sierpnia 2020 roku w oficjalnym serwisie F1 pojawił się artykuł szumnie zapowiadający wyłonienie, dzięki zaprzęgnięciu tzw. uczenia maszynowego (ang. machine learning), najszybszego kierowcy wyścigowego w historii Formuły 1. Chmura obliczeniowa plus tzw. sztuczna inteligencja a szybkość kręcenia kierownicą – przyznam, że brzmiało intrygująco. No i jak rozumiem przynajmniej na jakiś czas miało rozwiać wątpliwości kto w F1 jeździł najszybciej. Zanim wyjaśnię dlaczego osoby, które dopuściły się tej analizy, popełniły kardynalny błąd analityczny, przypomnę wszystkim scenę z kultowego Misia i słowa: ,,(…) teraz mamy komputer, może pan pisać co tylko pan chce, to nie ma żadnego znaczenia, on się i tak zawsze pomyli przy dodawaniu”.

Tzw. sztuczna inteligencja kontra poczciwa statystyka

Dla osób, które na co dzień nie zajmują się analizą danych (czyli dla większości), szumnie i górnolotnie brzmiące określenia, takie jak machine learning, sztuczna inteligencja czy obliczenia w chmurze robią na ogół wrażenie. Niestety, bardzo często pod tymi hasłami albo nie kryje się nic odkrywczego, albo – co jest już karygodne – schowane są wątpliwej jakości analizy, które zostały wykonane wbrew wszelkim regułom wnioskowania. Z drugiej strony jest statystyka, która jest bardzo wymagająca od strony formalnej i ekstremalnie wymagająca od strony zastosowań. Czym jednak różni się tzw. uczenie maszynowe od wnioskowania statystycznego?

Czym jest machine learning

Zacząć trzeba od tego, że machine learning nie jest sztuczną, a tym bardziej faktyczną, inteligencją. W dużym skrócie i przy sporej dawce ogólności jest to program (nie algorytm), który implementuje algorytmy pozwalające na ,,samouczenie się”. W rzeczywistości stosowany jest jakiś model danych (czasami bardzo prymitywny, czasami bardzo skomplikowany). I w trakcie analizy parametry tego modelu – wraz z dostarczaniem nowych danych – na bieżąco się koryguje. To jest właśnie to ,,samouczenie się” programu. Ale uwaga: ten model danych nie jest zaprojektowany do odkrywania zależności. On jest skonstruowany jedynie do podnoszenia zdolności predykcyjnej (ogólnie: prognostycznej) tegoż modelu. A zatem to ,,samo uczenie się” to zwykła re-parametryzacja. Natomiast ta ,,inteligencja” to zdolność to samodzielnego modyfikowania swoich parametrów tak, aby maksymalnie trafnie prognozować rzeczywistość. Podkreślam – prognozować, nie odkrywać i wyjaśniać!

Co może statystyka

Na drugim biegunie jest statystyka, w której wymaga się jawnej (często przybliżonej, ale jednak) specyfikacji charakteru zależności pomiędzy badanymi obiektami, kierunku możliwych interakcji w jakie one wchodzą oraz specyfikacji rozkładu dla modelowanego zjawiska. Do tego dochodzi sprawa estymacji modelu i jego testowania pod kątem zgodności z przyjętymi założeniami. I tutaj dochodzimy do sedna: tzw. uczenie maszynowe nie zakłada czegokolwiek przyjmując, że komputer ,,odkryje” schemat pozwalający na trafne przewidywanie. A jak wiemy, komputer się przecież nie myli. Statystyka z kolei wymaga przyjęcia i późniejszego spełnienia określonych założeń, starając się w ich ramach wskazywać na – wynikające z teorii – zależności między obiektami. Mamy tutaj zatem próbę wyjaśnienia mechanizmu rządzącego danym zagadnieniem. Osoby, które mi nie wierzą mogą przeczytać chociażby ten artykuł.

Podsumowując można powiedzieć, że tzw. uczenie maszynowe odpowiada na pytanie: ,,jak?”, natomiast statystyka odpowiada na pytanie: ,,dlaczego?”. Można to poprzez analogię porównać do sytuacji w cywilnej motoryzacji. Zdecydowana większość z nas jeździ samochodem i większość osób z tej grupy potrafi ocenić (sformułować prognozę) ile nasz samochód jeszcze przejedzie kilometrów zanim dokona swojego żywota. Z drugiej strony tylko osoby znające się na mechanice będą w stanie precyzyjnie wyjaśnić dlaczego tak będzie.

Nierzetelność Amazon Web Services

Jak możemy przeczytać w zgrubnym opisie metodyki analizy AWS przeprowadziła normalizację danych tak, aby były porównywalne. Przyporządkowała także wyższe wagi poszczególnym zawodnikom m.in. wtedy, kiedy dany kierowca był dominatorem na torach F1. Aby uwiarygodnić swoją analizę AWS podkreśla, że nad wszystkim czuwała Dr Priya Ponnapalli – Amazon ML Solutions Lab’s Principal Scientist and Senior Manager (a można jeszcze więcej określeń?). Problem w tym, że pani doktor nie jest statystykiem ani analitykiem danych, tylko wysokiej klasy specjalistką od technik machine learning-u. Niekoniecznie więc musi znać się na tym, co tak naprawdę firmuje swoim nazwiskiem, czyli wielowymiarowej analizie porównawczej. A co zrobili ,,analitycy” w AWS? Zastosowali metodę prognozowania w celu odkrywania ukrytych zależności. To hochsztaplerstwo!!!

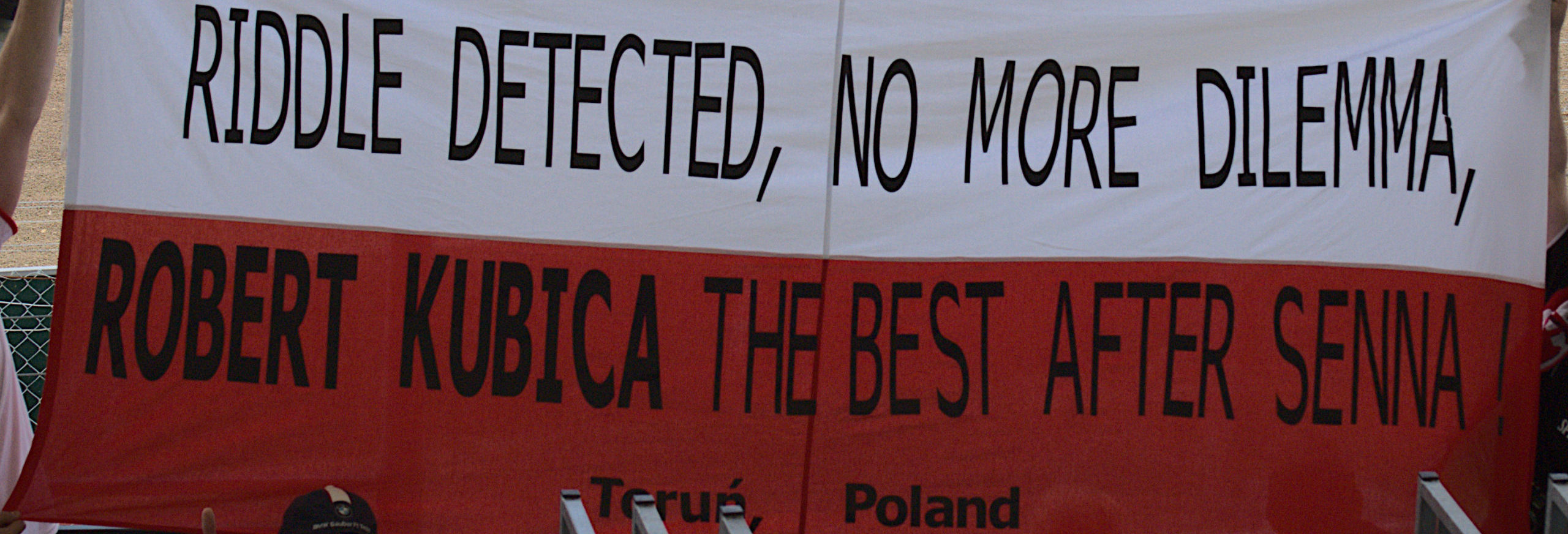

Czym zatem są wyniki uzyskane przez AWS i opublikowane w serwisie www.formula1.com? Od strony naukowej są bezwartościowe, ponieważ jest to przykład bardzo nierzetelnego badania polegającego na zastosowaniu nieadekwatnej metody do analizy oraz – co równie karygodne – bez krytycznego spojrzenia na uzyskane wyniki. Od strony dziennikarskiej to pewnie ciekawostka i to chyba bardzo kontrowersyjna, biorąc pod uwagę następujące wpisy:

Od strony czytelniczej (w tym kibicowskiej) to zabawa liczbami, która jednak dotyczy obecnych i byłych (w tym już niestety nie żyjących) kierowców. Nie jestem pewien, czy taka zabawa jest chociażby przyzwoita.

Podsumowanie

Amazon Web Services podjął się ciekawego zadania analitycznego: chmura obliczeniowa plus tzw. sztuczna inteligencja a szybkość kręcenia kierownicą. Brzmiało ciekawie. Po roku prac AWS,

Amazon Web Services, za pośrednictwem oficjalnego serwisu www.formula1.com ogłosił, że ,,machine learning reveals the fastest F1 driver of the past 40 years”. W mojej ocenie jedyne, co zostało ujawnione, to niekompetencja osób przygotowujących ww. ranking. Stosowanie metody służącej do odpowiedzi na pytanie ,,jak?” w celu wyjaśnienia mechaniki zjawiska, czyli odpowiedzi na pytanie ,,dlaczego?”, to daleko idąca manipulacja. To właśnie takie badania ugruntowują przekonanie, że są kłamstwa, okropne kłamstwa i statystyki. Generowanie zestawień wszech czasów samo w sobie nie jest niczym złym, ale przy ich tworzeniu musimy zachować rzetelność oraz stosować odpowiednie narzędzia, o czym kilka słów napisałem w moim wcześniejszym wpisie. Szczególnie mocno dziwi więc fakt, że Formuła 1, w której poziom analizy danych jest niespotykany, pozwala sobie na takie nieeleganckie ,,zabawy”.

Marcin

Jeden komentarz do “Ranking najszybszych kierowców F1 w historii, czyli dlaczego nie wolno bawić się liczbami”